畳み込みニューラルネットワーク(CNN)の中心的な構成要素は畳み込み演算子です。これにより、ネットワークは各層の局所受容野内で空間情報とチャネル情報の両方を融合することにより、有益な機能を構築できます。広範囲の先行研究がこの関係の空間コンポーネントを調査し、その機能階層全体で空間エンコーディングの品質を向上させることにより、CNNの表現力を強化しようとしています。

この記事では、2017年度のILSVRC(ImageNet Large Scale Visual Recognition Competition)で1位をとったSE(Squeeze-and-Excitation Networks)手法を紹介しています。トップ5エラーを2.251%に減らし、2016年の入賞エントリを約25%の相対的な改善で上回ったそうです。

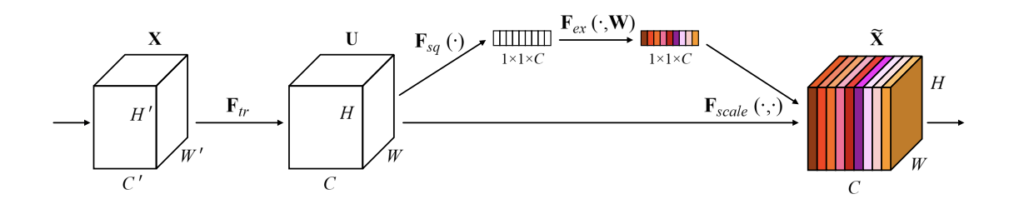

この手法は、チャネルの関係に焦点を当て、チャネル間の相互依存関係を明示的にモデル化することでチャネルごとの機能応答を適応的に再調整するSEブロックと呼ばれる新しいアーキテクチャユニットを提案します。要は畳み込み層の各チャンネルを均等に出力せず、適応的に重みをかけることがポイントだそうです。

ブロックを積み重ねて、異なるデータセットで非常に効果的に一般化するSENetアーキテクチャを形成できることを示しており、SEブロックは、わずかな追加の計算コストで、既存の最先端CNNのパフォーマンスを大幅に向上させることを論文中で示しています。

URL : https://arxiv.org/abs/1709.01507

Source code : https://github.com/hujie-frank/SENet