Facebookらが開発した衣服に統合できるソフトハプティックデバイス:PneuSleeve

ソフトハプティックデバイスを衣服に統合することで、日常のコンピューティングインタラクションの使いやすさと装着性を向上させることができます。

Facebook Reality Labの研究チームが、圧縮、皮膚の伸張、振動などの幅広い触覚刺激を与えることができる、ファブリックベースのコンパクトで表現力豊かな前腕スリーブであるPneuSleeveを開発し、2020年度のCHI会議に寄稿しています。

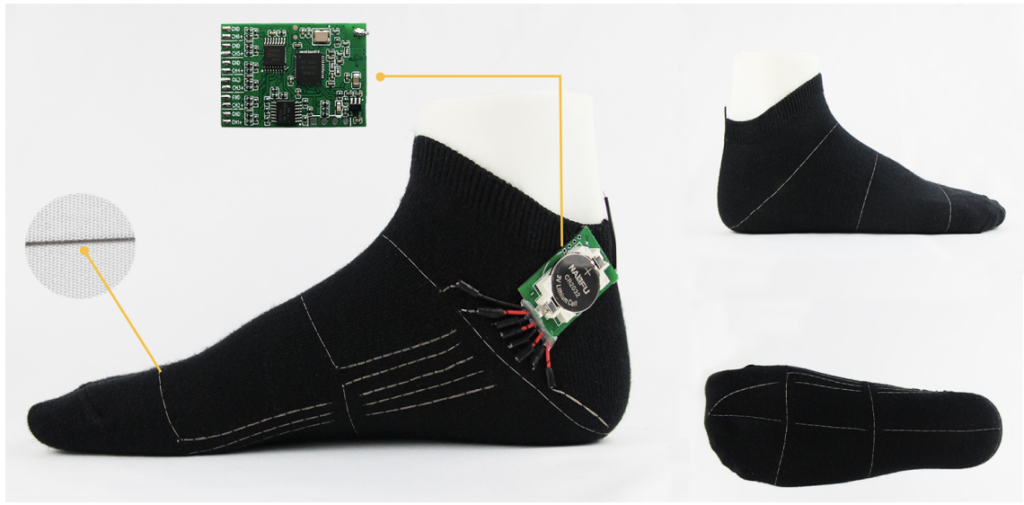

触覚刺激は、刺繍された伸縮性チューブ内の空気圧を制御することによって生成され、動作構成には、前腕の近位および遠位にある2つの圧縮アクチュエータと、前腕の周囲および接線に接する4つの均一に分配された線形アクチュエータが含まれるとしています。

さらに、適切なグリップ力を確保するために、2つのソフト相互静電容量センサーが配置され、圧縮アクチュエーターに統合、閉ループ力コントローラーが実装されています。アクチュエータの静的動作と動的動作、および閉ループ制御の性能を物理的に特徴付けます。

ユーザーの一連の研究で、6つのアクチュエータの心理物理学的特性を定量的に評価し、最後に、主観的評価を使用して複合触覚刺激を評価することにより、PneuSleeveの表現力を示しています。AR/VR researchチームの開発であることから、没入感を増すデバイスとして利用するための技術開発かもしれません。

Follow @aurordesign [1] : Zhu, M., Memar, A. H., Gupta, A., Samad, M., Agarwal, P., Visell, Y., … & Colonnese, N. (2020, April). PneuSleeve: In-fabric Multimodal Actuation and Sensing in a Soft, Compact, and Expressive Haptic Sleeve. In Proceedings of the 2020 CHI Conference on Human Factors in Computing Systems (pp. 1-12).